Подстройка весов скрытого слоя. Рассмотрим

(см. рис. 3.6). Когда значение δ получено, веса, питающие первый скрытый уровень, могут быть подкорректированы с помощью уравнений (3.5) и (3.6), где индексы модифицируются в соответствии со слоем.

(см. рис. 3.6). Когда значение δ получено, веса, питающие первый скрытый уровень, могут быть подкорректированы с помощью уравнений (3.5) и (3.6), где индексы модифицируются в соответствии со слоем.

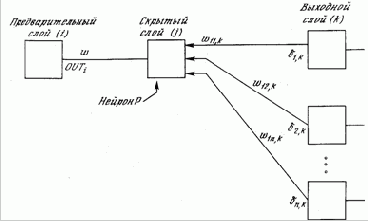

Рис. 3.6. Настройка веса в скрытом слое

Рис. 3.6. Настройка веса в скрытом слое

.Для каждого нейрона в данном скрытом слое должно быть вычислено δ и подстроены все веса, ассоциированные с этим слоем. Этот процесс повторяется слой за слоем по направлению к входу, пока все веса не будут подкорректированы. С помощью векторных обозначений операция обратного распространения ошибки может быть записана значительно компактнее. Обозначим множество величин δ выходного слоя через Dk и множество весов выходного слоя как массив Wk. Чтобы получить Dj, δ-вектор выходного слоя, достаточно следующих двух операций: Умножить о-вектор выходного слоя Dk на транспонированную матрицу весов W’k, соединяющую скрытый уровень с выходным уровнем. Умножить каждую компоненту полученного произведения на производную сжимающей функции соответствующего нейрона в скрытом слое. В символьной записи Dj = DkW’k $[0j $(I – 0j)], (3.8) где оператор $ в данной книге обозначает покомпонентное произведение векторов, Оj – выходной вектор слоя j и I – вектор, все компоненты которого равны 1.